Nell’ambito degli studi sui sistemi di privacy preserving, definiamo il privacy vs utility trade-off come problema tale per cui tanto maggiore è l’utilità che intendiamo trarre da un dato, quanto minore ne sarà la privacy preservata.

Tenuto presente che di questi tempi tutti parlino di privacy, sebbene sembri che nessuno realmente ne capisca non solo il significato, ma anche le implicazioni, ho deciso di aggiungermi alla massa; seppur distinguendomi.

Crediamo nella suprema entità idealizzata dal nostro caro amico Seth Godin: la mucca viola.

Sapersi distinguere in un mondo fotocopiato, è un must!

Tornando a noi…

Intendo presentarti una riflessione sulla quale pochi sembrano porre la giusta attenzione.

Nella nostra bolla individuale, di egoismo quotidiano, tendiamo a pensare che il problema della privacy riguardi la diffusione dei dati a un livello microscopico: il mio conto in banca, la tua cartella clinica, e via dicendo.

In realtà sottovalutiamo la reale portata della questione.

Casi come quello di Cambridge Analytica ci ricordano che a essere a rischio è anche la più ampia sfera sociale: la violazione di dati aggregati costituisce un pericolo per la società e la democrazia.

Inquadrato il problema, comprendiamolo meglio.

Quando si tratta di proteggere i così detti personally identifiable information (PII), è facile dare vita a una dicotomia in costante tensione tra protezione dati e qualità degli stessi: due estremi di una complessa bilancia.

Sfatiamo il mito: la soluzione di “perfect data anonymization” non esiste.

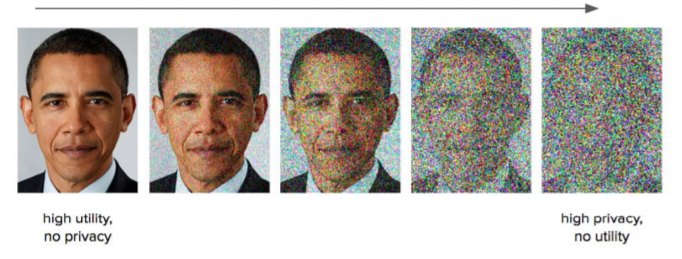

Aircloak, azienda specializzata in Privacy-Preserving Analytics per business di tipo data-driven, ci fornisce un semplice grafico con cui descrivere il privacy vs utility trade-off:

Il grafico è sufficientemente autoesplicativo, anche se un commento di corredo immagino sia sempre ben accetto.

La soluzione ideale, per logica impossibile, può essere approssimata accettando un compromesso tra massima privacy, e minima utilità, e viceversa.

L’Eden ricercato è quindi compreso tra bassa qualità dei dati e insufficiente privacy.

Ah certo…

L’utilità è in questo contesto sinonimo di qualità.

Dobbiamo disporre di dati di alta qualità, affinché le nostre analisi siano proficue e i nostri modelli utili; tuttavia andando a preservare la privacy capita sovente di dover degradare i dati in nostro possesso, intaccandone il valore, talvolta al punto tale da renderli inutilizzabili.

L’esempio migliore ce lo fornisce la computer vision:

A nessuno piace essere ripetitivi: ti chiedo scusa se in questo post mi vedo costretto a ripetere più volte a parola con la “P”

Con l’intento di preservare la Privacy di Barack Obama procediamo a degradare l’immagine aggiungendo rumore casuale (random noise) al punto tale da rendere il presidente americano irriconoscibile: possiamo dire di aver messo in sicurezza la sua identità.

Possiamo anche prendere quell’immagine e buttarla nel cestino dei rifiuti.

Come sempre, un concetto apparentemente complesso ridotto a semplici elementi di più agile comprensione.

Per il momento è tutto!

Ti lascio a un articolo accademico per maggiori approfondimenti.

P.S.

Stavo effettuando alcune ricerche per arricchire il contenuto del post quando mi sono imbattuto in una pagina che prende seriamente il tema privacy:

L’errore HTTP 451 è uno standard (come il 404 per le risorse non trovate) per indicare contenuti censurati per motivi legali, come quello in questione.

In attesa del prossimo post…

Un caldo abbraccio, Andrea.