L’ Information Entropy (Entropia dell’informazione), anche chiamata Shanon Entropy o semplicemente Entropy, è il calcolo della quantità minima di dati, necessari a trasmettere l’informazione posseduta da una variabile randomica.

FINE.

Siamo amici, l’onestà è fondamentale. Non ho capito un singolo bit.

Procediamo con ordine.

Information Entropy: deduzione significato

Immagina di aver davanti a te due pacchi:

- Pacco A: contiene una sciarpa o un calzino

- Pacco B: contiene un oggetto strepitoso

Quale pacco è più emozionante?

A meno che tu non debba scalare l’Everest, penso sia ovvio che dell’oggetto strepitoso non te fai nulla. Dammi la sciarpa!

Ovviamente il pacco contenete una sciarpa o un calzino, prevedibile e noioso, suscita in noi ben poche emozioni rispetto all’eccitazione che potremmo avere nell’aprire quello misterioso.

Cambiando punto di vista, potremmo dire a ragion veduta che la nostra conoscenza personale aumenterebbe se evitassimo di aprire il pacco contenente la sciarpa, e scegliessimo il secondo.

Ne scopriremmo il contenuto, e con esso avremmo una nuova informazione.

I matematici in ascolto, amanti della formalità, direbbero che il pacco B ha un’entropia maggiore del pacco A. L’entropia definisce in questo caso la mancanza di ordine e prevedibilità.

L’Entropia misura l’incertezza

Information Entropy: il meteo

Approfondiamo ulteriormente il significato di entropia nella teoria dell’informazione, con un secondo esempio!

Ora, diventiamo meteorologi

Il nostro amico Seth, dovo averci parlato di come diventare una mucca viola, ci chiede d’inviargli giornalmente le previsioni meteo per la sua località.

Ora supponiamo di codificare il meteo in 8 stati differenti (pioggia, sole, grandine, nuvoloso, etc.) e di usare il sistema binario:

001 110 111

010 011 000

100 101

Per ogni trasmissione abbiamo bisogno di 3 bits d’informazione.

E’ agosto, e le previsioni meteo prevedono sole a palla per i prossimi 15 giorni, ma il nostro amico Seth si ostina a voler ricevere il bollettino meteo ogni singolo giorno.

Allora, da persone intelligenti, codifichiamo l’evento più probabile in modo da risparmiare spazio, con un singolo bit: 0 (invece di tre, 000).

Questo può avvenire a discapito delle altre 7, che devono essere codificate usando 4 bits.

L’entropia per le previsioni meno probabili aumenta, e diminuisce per quelle più probabili.

Riprenderemo questo esempio parlando di Cross-Entropy, ma per il momento è bene concentraci sul concetto generale.

Where we put information?

Un’informazione è utile solo nel caso in cui possa essere salvata su qualche supporto o comunicata, quindi trasmessa. C’è un che di filosofico in tutto questo, ma per il momento concentriamoci sui soli fatti.

Ti è mai capitato di scattare foto con una reflex senza scheda di memoria? La foto è utile solo nel caso in cui venga effettivamente salvata, altrimenti è persa…

A livello informatico, ogni singolo pezzo d’informazione è codificato in una sequenza di bit, ciascuno dei quali può assumere uno dei due possibili valori: 0 o 1.

Questo piccolo excursus è fondamentale perché la trasmissione delle informazioni e il loro salvataggio sono quasi la medesima cosa.

Tieni a mente il termine bit.

Ok quindi dovremmo parlare di Information Entropy, Information Theory e per il momento abbiamo discusso di sciapre, everest, reflex e pacchi., e previsioni meteo. Niente male!

Claude Shannon

Claude Shannon è considerato il padre della teoria dell’informazione.

L’Information Theory è dunque quella disciplina, branca dell’informatica, che studia i fenomeni relativi alla trasmissione e alla misurazione delle informazioni.

L’assunto fondamentale da cui la teoria dell’informazione muove è l’idea secondo cui un evento che produce in noi sorpresa ha un contenuto informativo maggiore:

- High Probability Event: Low Information and Unsurprising

- Low Probability Event: High Information and Surprising

Ora, il nostro caro amico Claude ebbe una strabiliante intuizione.

Tanto più prevedibile un’informazione diventa, tanto meno spazio è richiesto per archiviarla.

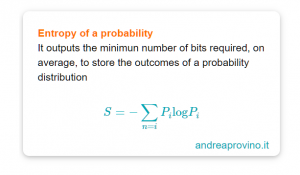

Trattandosi di un matematico, uno bravo, Claude elaborò una formula per descrivere l’entropia:

Rappresenta il numero minimo di bit necessari in media per registrare l’outcome di una distribuzione statistica.

La probabilità che all’interno del pacco A ci fosse una sciarpa costituisce un’informazione che occupa spazio, meno di quello richiesto per salvare l’informazione rappresentata dalla probabilità di trovare un unicorno rosa nel pacco B, perché le possibilità sono minori: evento raro.

L’entropia lega quindi la probabilità con l’informazione a essa associata.

Un evento certo ha un’entropia minima: zero.

Information Entropy e Machine Learning

L’information theory e il concetto di entropia è fondamentale per comprendere la due concetti importanti nella data science:

- cross-entropy e Kullback-Leibler divergence

Nel caso in cui la previsione di un evento fosse corretta, allora la cross-entropy sarebbe uguale all’entropia dell’evento in sé. Qualora fosse errata, la cross-entropy sarebbe superiore, pari al cosidettò Kullback-Leibler divergence.

Non temere, lo approfondiremo assieme più avanti.

Si tratta di termini che devono essere definiti nel vocabolario di ogni machine learning engineer o data scientist che si rispetti.

Altrimenti come pensi di entrare nel team aziendale?

Il calcolo dell’informazione e dell’entropia è inoltre utile poiché alla base di tecniche quali la selezione delle features (features selection), la creazione di alberi decisionali e più in generale per la creazione di modelli di classificazione.

Sono concetti chiave del machine learning, e dobbiamo approfondirli. Per non perderti nemmeno un post, e avere accesso a contenuti strepitosi, iscriviti alla newsletter!

Un caldo abbraccio, Andrea.